No todo es miel sobre hojuelas en el desarrollo de la Inteligencia Artificial, a pesar de su avance significativo en los últimos años, han comenzado a surgir preocupaciones sobre la disposición de grandes cantidades de datos para el entrenamiento de modelos. Una salida es el uso de datos sintéticos, pero también enfrentan retos.

Los grandes modelos de lenguaje [LLM, por sus siglas en inglés] podrían quedarse sin datos en menos de una década, concluye un informe de la organización Human-Centered Artificial Intelligence la Universidad de Stanford. Una de las soluciones propuestas es el uso de datos sintéticos, pero también presentan retos.

Jack Clark, miembro del Comité directivo del Índice de Inteligencia Artificial (IA), indicó que en la actualidad ya se han entrenado modelos fundacionales con un volumen significativo de los datos disponibles en Internet. La dependencia de los modelos de la IA por datos disponibles en la Red han despertado preocupaciones ante su eventual agotamiento.

El instituto de investigación Epoch ha realizado proyecciones para estimar el momento en que la IA podría quedarse sin datos. Con base en la evolución del uso de datos para entrenar modelos fundacionales, los investigadores obtuvieron algunos cálculos a futuro. Por ejemplo, concluyeron que los científicos podrían quedarse sin datos lingüísticos de alta calidad en 2024 y los de baja calidad podrían consumirse en dos décadas. Los datos que se mantendrían por más tiempo sin agotarse serían los de imagen, pero incluso estos estarían agotados para finales de la década de 2030 o mediados de la del 2040.

DATOS SINTÉTICOS: UNA SOLUCIÓN LIMITADA

La Universidad de Stanford expone que en teoría la escasez de datos podría ser superada mediante el uso de datos sintéticos, es decir, datos generador por los propios modelos de IA. Estos datos podrían ser utilizados para capacitar a otros modelos.

Los investigadores consideran este método no solo una solución para hacer frente al inminente el agotamiento de datos, sino también para generarlos en algunos campos donde son escasos, como son algunas enfermedades poco comunes, o los grupos de población subrepresentados.

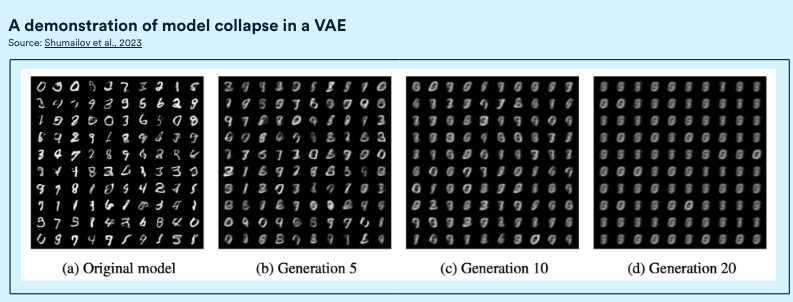

Sin embargo, nuevas investigaciones sugieren que existen limitaciones en el uso de datos sintéticos para entrenar modelos. Una equipo canadiense encontró que eventualmente, algunos modelos entrenados con datos sintéticos colapsan y con el tiempo llegan a olvidar la distribución de datos subyacentes, produciendo un rango más estrecho de resultados.

Con cada generación, el modelo genera productos menos variados. Esto puede ocurrir en modelos de mezclas gaussianas y en modelos de lenguaje a gran escala. En el caso de los modelos de imágenes generativas, los investigadores descubrieron que llega un punto en que la calidad de la producción experimente una caída considerable.