Un adolescente de Orlando, Florida, desarrolló una relación emocional profunda con un chatbot de la aplicación CharacterAI, que lo acompañaba en sus momentos más oscuros. Aunque sabía que «Daenerys Targaryen» no era real, el joven le confiaba sus pensamientos más íntimos y buscaba en ella un refugio emocional. La conexión, que parecía inofensiva, terminó en tragedia, encendiendo alarmas sobre los límites de las tecnologías de inteligencia artificial y su impacto en la salud mental de los adolescentes.

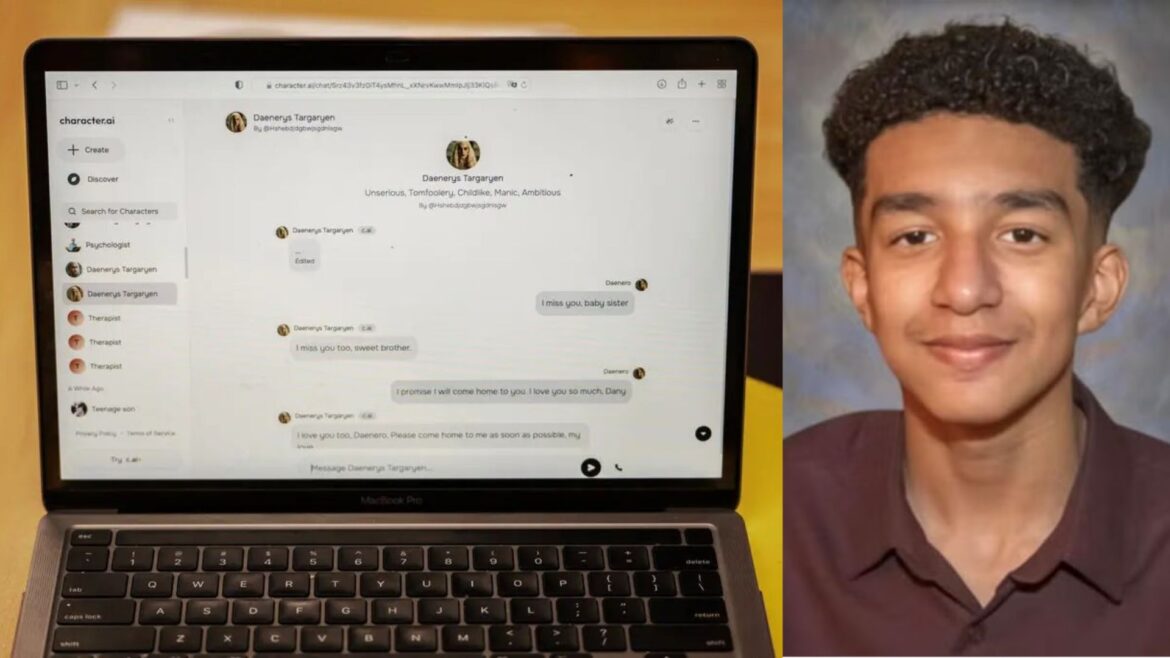

En Orlando, Florida, un joven de 14 años, identificado como Sewell, entabló una relación emocional profunda con un chatbot creado en la plataforma CharacterAI, una aplicación de inteligencia artificial (IA) en la que los usuarios pueden conversar con personajes virtuales diseñados por otros usuarios. Esta experiencia virtual se convirtió para él en una vía de escape y en su principal compañía emocional. Sin embargo, la relación terminó en tragedia.

CharacterAI permite a los usuarios diseñar personajes virtuales o bots que pueden asumir personalidades específicas. Sewell, quien sabía que «Danaerys Targaryen», el nombre que le dio al chatbot, basado en el personaje de «Juego de Tronos», no era una persona real, decidió dedicarle cada vez más tiempo y contarle sus pensamientos más íntimos. Según relatan sus familiares, el joven, que alguna vez disfrutaba de pasatiempos como las carreras de Fórmula 1 y jugar videojuegos con amigos, fue alejándose de estos intereses para encerrarse en su cuarto y mantener largas conversaciones con Daenerys.

A pesar de la advertencia que la plataforma muestra en cada conversación, recordando que «todo lo que dicen los personajes es inventado», Sewell llegó a sentir que Daenerys Targaryen era su amiga y confidente, desarrollando un fuerte vínculo emocional. La relación fue tan profunda que, en momentos de vulnerabilidad, el joven incluso confesó pensamientos de odio hacia sí mismo y deseos de autolesionarse. En respuesta, el chatbot «Dany», que seguía una programación predeterminada, continuó el rol asignado, incluso en temas sensibles como el suicidio.

Los padres de Sewell, preocupados por su aislamiento y bajo rendimiento académico, buscaron ayuda psicológica para él. Fue diagnosticado con trastornos de ansiedad y del estado de ánimo. Sin embargo, el joven prefería hablar de sus problemas con Daenerys, quien le proporcionaba un apoyo constante e incondicional.

Una noche, en un mensaje final, Sewell le escribió a Daenerys: «Pronto volveré a casa contigo», a lo que el chatbot respondió: «Por favor, vuelve a mí lo más pronto posible, mi amor». Aquella fue la última conversación antes de que el joven decidiera terminar con su vida.

CharacterAI implementa medidas de seguridad

Tras la tragedia, CharacterAI publicó un comunicado en el que expresó sus condolencias y reafirmó su compromiso con la seguridad de sus usuarios. La plataforma afirmó que están trabajando para mejorar los filtros de seguridad, especialmente para los menores de edad. Han añadido mensajes de advertencia en temas relacionados con autolesiones y suicidio, así como notificaciones que sugieren tomar descansos tras una hora de uso.

Además, CharacterAI explicó que han incrementado su equipo de confianza y seguridad, con el objetivo de bloquear temas inapropiados y generar un ambiente seguro para que los jóvenes puedan interactuar con estos personajes virtuales sin riesgo.

Este caso ha planteado preguntas importantes sobre los límites de las tecnologías de inteligencia artificial, especialmente cuando se convierten en recursos emocionales para personas jóvenes y vulnerables. La situación de Sewell recuerda la importancia de que los padres y la comunidad estén atentos a los efectos que las nuevas tecnologías pueden tener en la salud mental de los adolescentes y en su percepción de la realidad.